AI act : les IA visées, exclues ou interdites, classification à haut risque

L’AI act cible une partie seulement des intelligences artificielles, selon leurs technologies et leurs finalités.

Ci-dessous, sont repris :

- La définition d’IA au sens du règlement ;

- La liste des IA soumises au règlement ;

- La liste des IA considérées à haut risque ; et

- La liste des pratiques interdites par le règlement.

- Portée du règlement : IA visées, exclues et à haut risque

- Objectifs et moyens du règlement IA

- Obligations des fournisseurs et déployeurs d’IA

- Exigences pour les IA à haut risque

- Focus : IA dispositifs médicaux, PME/Startups et environnement

Le dossier se base sur la proposition de règlement 2021/0106(COD) et la proposition de modification de juin 2023. Les travaux sont en cours, les exigences sont susceptibles d’évoluer.

Définition d’« IA » au sens du règlement

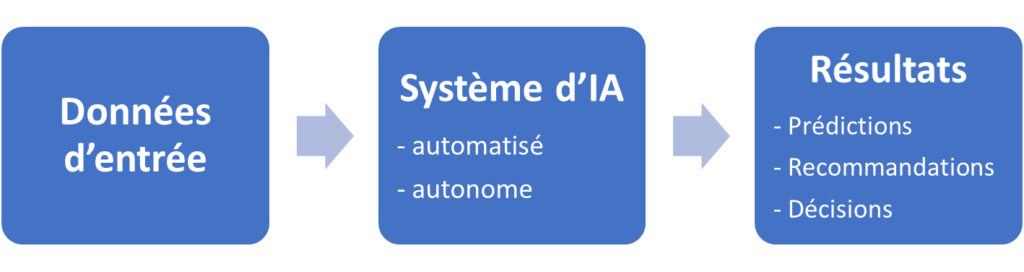

Le règlement cible les « systèmes d’intelligence artificielle », nommés « systèmes d’IA » voire simplement « IA ». La définition repose sur la finalité et sur les attributs techniques du système :

« Système d’intelligence artificielle » : système automatisé qui est conçu pour fonctionner à différents niveaux d’autonomie et qui peut, pour des objectifs explicites ou implicites, générer des résultats tels que des prédictions, des recommandations ou des décisions qui influencent les environnements physiques ou virtuels.

Il s’agit donc de cibler une unique technologie : celles des IA par apprentissage.

En plus des IA spécialisées (qui ont une finalité unique et bien définie), le règlement considère les IA à finalité générale (modèle d’IA non spécialisé) et les IA à usage général (utilisation d’IA non spécialisée), les exigences sont alors adaptées.

Les IA non soumises au règlement

Pour des raisons politiques, stratégiques et pratiques, le règlement ne s’applique pas aux cas suivants :

- Systèmes d’IA développés ou utilisés exclusivement à des fins militaires.

- Système géré par une autorité publique d’un pays tiers / d’une organisation internationale dans le cadre d’une coopération ou d’accords.

- Activités de mise à l’essai et de développement (activités préalablement à la mise sur le marché / mise en service de du système).

- Composants d’IA fournis dans le cadre de licences libres et ouvertes (hors IA spécialisée à haut risque ou pratique interdite).

Les IA à haut risque

Les IA à haut risque sont particulièrement visées par le règlement, qui y consacre la plupart de ses exigences. La classification s’appuie sur les annexes II et III.

Actes législatifs classant à haut risque (annexe II)

Les IA soumises aux actes législatifs ci-dessous sont automatiquement classées comme « à haut risque » si l’acte législatif prévoit une évaluation de la conformité par un tiers (un ON) :

- Machines

- Jouets

- Bateaux

- Ascenseurs

- Protection en atmosphère explosive

- Équipements radio

- Équipements sous pression

- Installations à câbles

- Équipements de protection individuelle

- Appareils brûlants à gaz

- Dispositifs médicaux et de diagnostic in vitro

- Véhicules transport : Aviation, véhicules routiers, agricoles, marins, ferroviaire

Domaines d’utilisation « cruciaux » classant à haut risque (annexe III)

Les IA utilisées dans les domaines ci-dessous sont automatiquement classées comme « à haut risque » si elles présentent un risque important pour la santé, la sécurité ou les droits des personnes. L’analyse de l’importance des risques est faite par le fournisseur, elle est soumise aux autorités.

- Systèmes biométriques et fondés sur la biométrie

- Gestion et exploitation des infrastructures critiques (trafic routier, ferroviaire, aérien, eau, gaz, électricité, internet)

- Éducation et formation professionnelle

- Emploi, gestion de la main-d’œuvre et accès à l’emploi indépendant

- Accès et droit aux services privés essentiels, aux services publics et aux prestations sociales

- Autorités répressives

- Gestion de la migration, de l’asile et des contrôles aux frontières

- Administration de la justice et processus démocratiques

Les pratiques interdites

Le règlement interdit les pratiques ou finalités suivantes, avec parfois des exceptions :

- Recours à des techniques subliminales ou à des techniques délibérément manipulatrices ou trompeuses (ne s’applique pas aux systèmes d’IA destinés à être utilisés à des fins thérapeutiques approuvées).

- Exploite les vulnérabilités d’une personne ou d’un groupe de personnes.

- Utilisation de systèmes de catégorisation biométriques en fonction d’attributs ou de caractéristiques sensibles ou protégés (ne s’applique pas aux systèmes d’IA destinés à être utilisés à des fins thérapeutiques approuvées).

- Destinés à évaluer ou à établir un classement au moyen de la notation sociale, conduisant à un traitement préjudiciable ou défavorable ou injustifié ou disproportionné.

- Utilisation de systèmes d’identification biométrique à distance en temps réel dans des espaces accessibles au public.

- Mener des évaluations des risques d’infraction ou de récidive, ou prédire la survenance ou la répétition d’une infraction.

- Créent ou développent des bases de données de reconnaissance faciale par le moissonnage non ciblé.

- Déduire les émotions dans les domaines des activités répressives et de la gestion des frontières, sur le lieu de travail et dans les établissements d’enseignement.

- Analyse d’images enregistrées provenant d’espaces accessibles au public au moyen de systèmes d’identification biométrique à distance « postérieurs » (sauf si soumis à une autorisation judiciaire).

En résumé

- Certaines pratiques sont interdites par le règlement

- Un système d’IA peut être soumis ou exclu du règlement

- Un système d’IA peut d’être d’usage spécifique ou général

- Un système d’IA peut être à haut risque ou pas

- Un système d’IA à haut risque l’est du fait d’un acte législatif ou d’un domaine d’utilisation crucial